离子注入电源的剂量精准控制技术研究

离子注入技术是半导体制造的核心工艺之一,其精度直接影响器件的电学性能与良率。高压电源作为离子注入系统的能量来源,其剂量控制精度(通常需达±1%以内)是保障注入均匀性与重复性的关键。本文从技术挑战、控制架构及发展趋势三方面展开分析。

一、剂量控制的技术挑战

1. 束流稳定性与噪声干扰

离子束流的波动(如±5%)会直接导致剂量偏差。主要干扰源包括:

电源噪声:高压加速模块的电压波动影响离子能量一致性;

束流散射:传输过程中的碰撞导致束流密度分布不均;

环境干扰:真空度变化(影响离子运动路径)和温度漂移(改变材料晶格结构)。

2. 多参数耦合影响

剂量精度受能量、束流强度、扫描速度等多参数耦合影响。例如:

能量偏差1%可能导致注入深度偏移3%-5%;

扫描系统同步误差(如机械磨损)会引发剂量均匀性误差(>2%)。

二、数字化控制系统的核心架构

现代离子注入电源采用全数字化闭环控制,其架构包含三个层级:

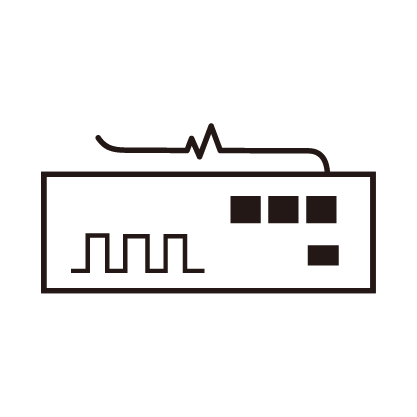

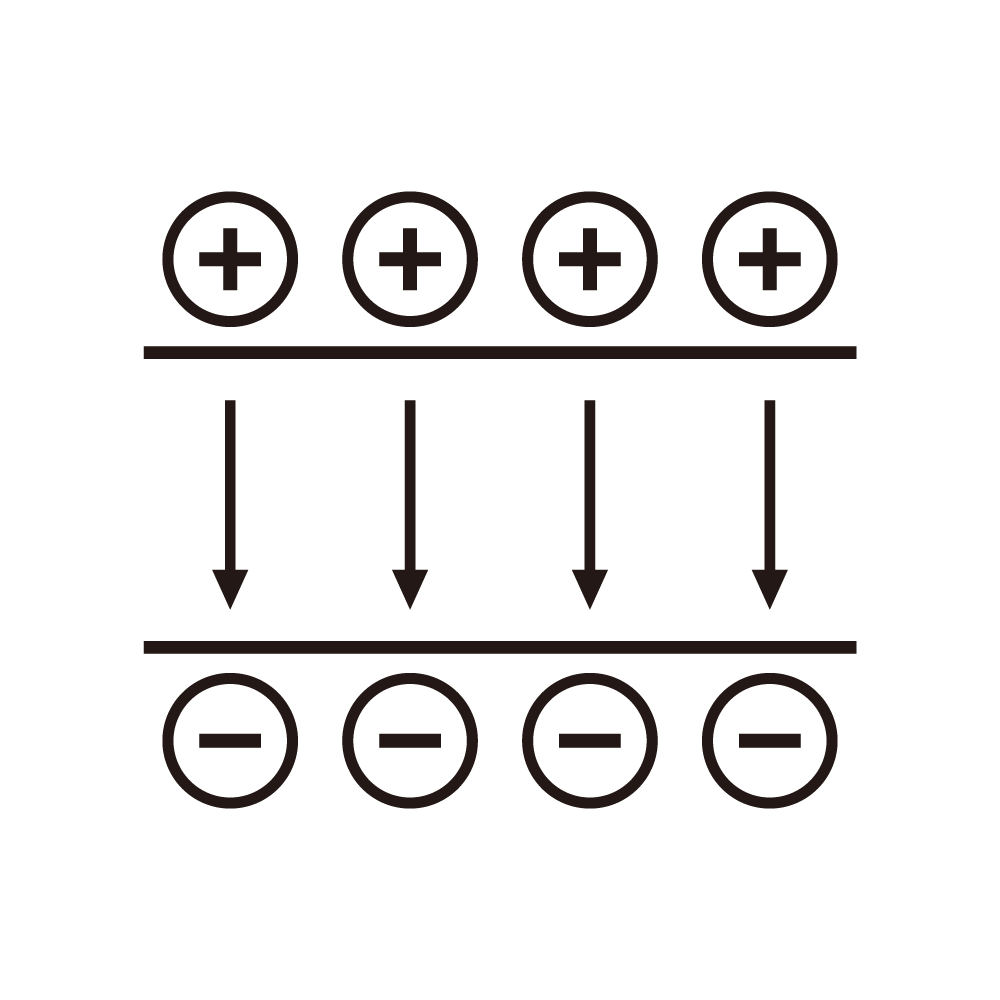

1. 实时数据采集层

双路积分电路:交替采集束流值,确保数据连续性(采样频率达kHz级),避免传统单路采集的漏检问题;

多传感器融合:集成电流、电压、温度及真空度传感器,通过ADC模块实现高精度数字化(分辨率≤0.1%)。

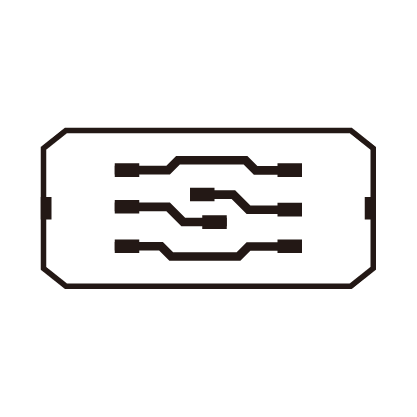

2. 智能反馈控制层

自适应算法:根据实时剂量误差动态调整增益参数(如PID控制器结合机器学习模型),降低过程波动;

前馈补偿机制:预测加速电压波动并预调整输出,减少能量误差(补偿效率>90%)。

3. 冗余容错设计

硬件冗余:双DA模块独立控制X/Y轴向扫描电源,确保单点故障不影响系统运行;

自诊断系统:启动前对电路性能自检,运行中实时分析参数合理性,异常时自动切换至最优历史工艺参数。

三、前沿趋势:智能化与多物理场协同

1. AI驱动的工艺优化

利用深度神经网络建立剂量-参数映射模型,实现:

剂量预测:输入目标剂量后自动生成最优工艺参数组合;

实时修正:通过在线监控数据动态调整扫描速度与束流强度,均匀性控制可达±0.8%。

2. 高功率密度与能效平衡

第三代半导体器件:采用SiC/GaN功率模块,提升开关频率(>100kHz),降低能耗30%;

液冷散热设计:结合热仿真模型优化散热路径,保障高压电源在兆伏级输出下的稳定运行。

结论

离子注入电源的剂量精准控制已从单一参数调控发展为多物理场协同的智能化体系。未来需进一步探索量子传感技术(提升测量精度)与数字孪生模型(实现虚拟工艺调试),以应对3D集成芯片与二维材料等新型器件的注入挑战。